В основном перешел на Claude. Почти интуитивно уже понимает промты. ChatGPT надо постоянно корригировать.

А вот подтверждение

Пропаганда at scale

The scale and sophistication of the operation were made possible by the use of ChatGPT, an artificial intelligence tool created by OpenAI

Вот тебе гораздо более “земной” пример, отсюда и ниже)

ИИ в массы, приложение Шедеврум.

Зато можно попросить продолжить книгу, гугл так не умеет

Денис Тулинов сегодня в Telegram:

Пузырь генеративного ИИ начал лопаться, считает Маркус. Он упрекает обучателей крупнейших нейросеток в том, что у них нет внятной бизнес-модели, которая окупила бы гигантские затраты этого сектора. Вложены уже сотни млрд. $, а главный вопрос надежности/галлюцинаций так и не решен, что резко ограничивает применимость технологии.

Он и не будет решен, т.к. это неотъемлемое свойство GenAI, настаивает Маркус.

В целом он твердит об этом давно, но теперь предрекает крах уже в этом году: “Пользователи потеряли веру, клиенты потеряли веру, венчурные инвесторы потеряли веру”. Возможно, его сподвиг недавний отчет Goldman Sachs “Gen AI: too much spend, too little benefit?”, где проводится та же мысль, более мягкими словами (см. также разбор отчета).

Несмотря на ряд успехов GenAI, например, в генеративной (био)химии, можно видеть, как тускнеют ожидания и как меняется тон комментариев, не только у Маркуса. Все наигрались в генерацию картинок/текстов и хотят, наконец, использовать ИИ в реальных задачах. Но этот переход не дается — в силу самой природы GenAI. Ключевой изъян в том, что GenAI беззащитен перед т.н. “выбросами”. Если на входе паттерн, сильно отличный от паттернов в обучающей выборке, на ответ нельзя положиться. Такой ИИ не понимает и не мыслит, он создает новые данные по шаблону старых.

Масштабирование не избавит от проблем (см. “AI scaling myths”). Метрики, где ИИ превосходит людей в решении задач, не измеряют интеллект/мышление, а превосходство может быть хрупким. Синтетические данные — не панацея от дефицита данных для обучения, такой маневр быстро ведет к коллапсу, т.к. каждая следующая модель учится не на реальности, а на предсказании реальности предыдущей моделью, и даже малые ошибки итеративно усиливаются.

Теперь будут программисты на GPT с нечеткой логикой

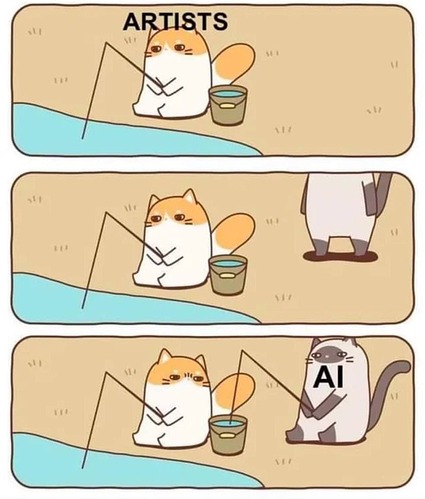

Первые реальные жертвы “творчества” ИИ

Робот не может навредить человеку. А человек — может.

Робот “поможет” человеку навредить эффективнее.

Таня Шаврина — умница и красавица